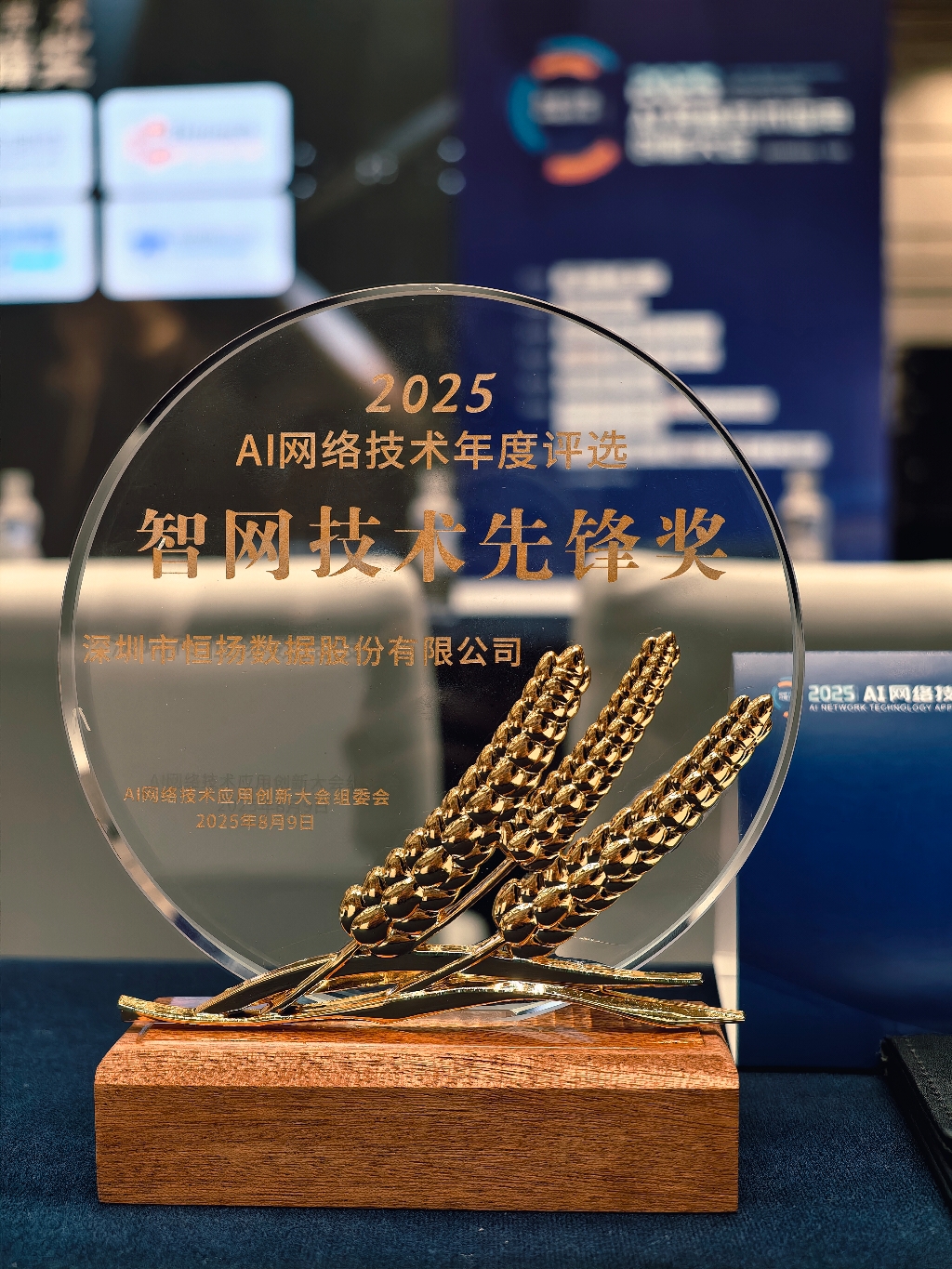

恒扬数据亮相 2025 AI网络技术应用创新大会并斩获智网技术先锋奖

发表时间:2025-08-10

返回列表2025年8月9日,备受瞩目的 “2025 AI网络技术应用创新大会” 在北京隆重召开。本次大会聚焦AI算网技术、智能应用场景、开源生态协同、智能网络大模型等主题,吸引了众多行业领军企业、专家学者参与。作为业界领先的智能计算和数据处理产品及应用解决方案提供商,恒扬数据NSA系列加速卡以其卓越的性能和行业最早实现十万卡级AI网络应用部署的领先优势,特别荣获2025 AI网络技术年度评选大赛”智网技术先锋奖“ ,同时产品经理兼资深技术专家陈平发表了题为《FPGA/DPU在高性能AI网络中的应用实践》的主题演讲,现场介绍了FPGA/DPU AI网络Scale Out相关技术实现及应用思考,引发广泛关注。

FPGA/DPU技术在AI网络Scale Out相关技术分享

随着 AI 模型规模呈爆炸式增长,高浮点算力需求、大规模并行计算、高效互联网络等成为核心诉求,而 “通信墙”“显存墙”“计算墙” 则是制约 AI 训练与推理效率的主要瓶颈。

针对这些痛点,陈平表示:FPGA/DPU凭借灵活性、可重构性、高吞吐、低延时四大核心优势,已成为突破AI网络性能瓶颈的关键技术:

• 低延迟突破

通过硬件逻辑直通,FPGA/DPU可绕过操作系统和协议栈,实现纳秒级处理速度,解决传统网络协议栈带来的高延迟问题; • 并行处理能力

FPGA/DPU内部逻辑单元独立,支持硬件级并行计算,完美适配AI训练中All-reduce 等高频通信操作; • 动态适配性

相比ASIC芯片的固定逻辑,FPGA可快速重构硬件逻辑,适应AI算法迭代、协议更新等需求,显著缩短技术落地周期; • 硬件级优化

恒扬数据在FPGA /DPU上实现了AI Collective通信硬件卸载、在网计算(数据传输中完成聚合 / 归约处理)、智能拥塞控制(如优化版 DCQCN 算法)等创新功能,有效提升了AI集群的通信效率与稳定性。

在FPGA/DPU领域的技术积累方面,从2008年推出10G加速卡开启异构计算探索,再到2021年2x200G AI网卡批量应用于AI数据中心,直至2024年 1x400G AI网卡规模化部署,再到目前800G AI网卡探索,这一系列技术演进,印证了恒扬数据在FPGA/DPU领域的深厚积淀及实践足迹。未来,恒扬数据将继续深化FPGA/DPU技术在AI网络中的应用,聚焦800G AI NIC高速率网络、定制化流控算法、深度优化场景等方向,助力AI集群实现 “更高效、更便捷、更稳定” 的计算体验。

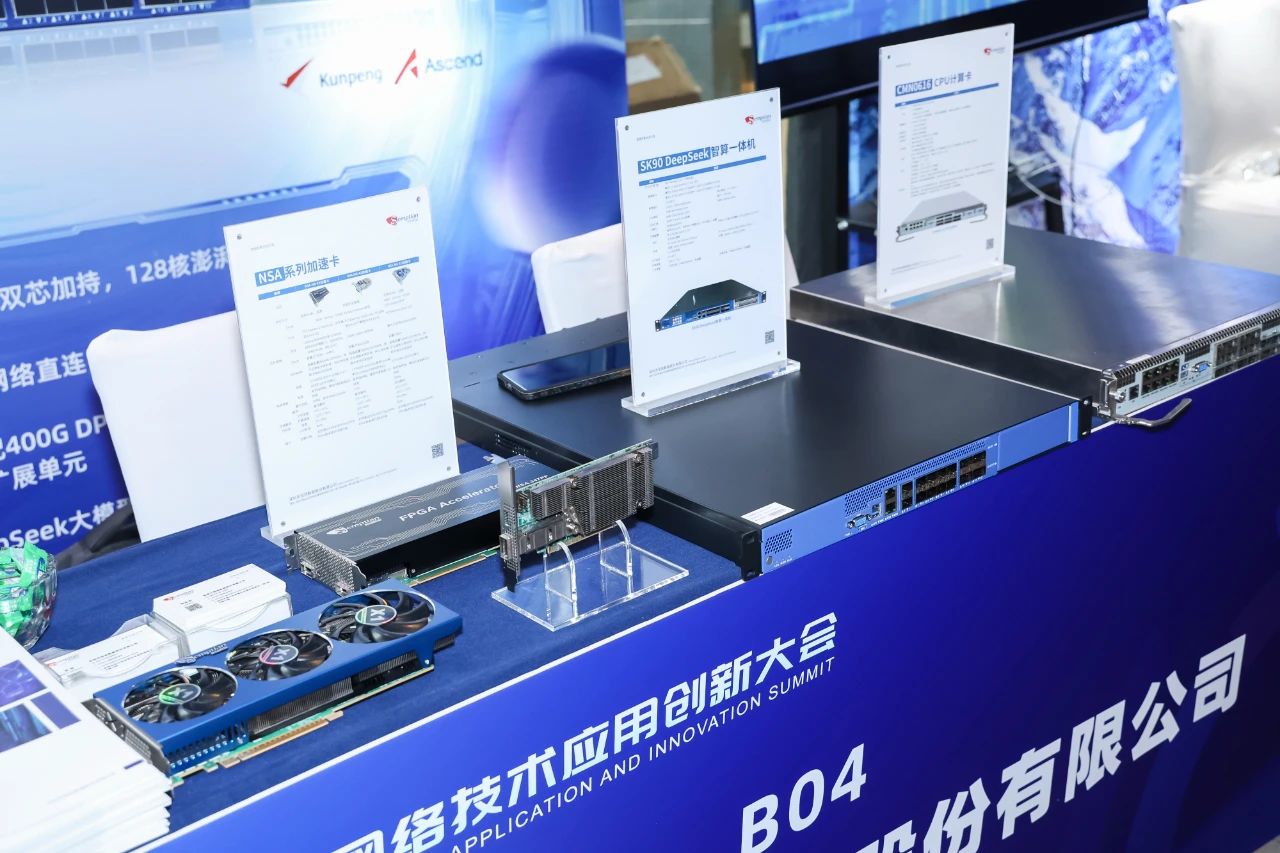

SK90 DeepSeek智算一体机现场亮相:高密度设计赋能大模型本地化部署

除技术分享外,恒扬数据在大会现场展示了众多AI网络相关产品,其中 SK90 DeepSeek智算一体机,以专为大模型本地化部署与边缘AI场景设计,“超强算力 + 高效互联 + 开箱即用” 为核心亮点,成为本次展会的关注焦点。

• 双芯加持

• v灵活 AI 算力扩展

配备 2 个 PCIe 4.0 x16 插槽,支持 2 张单槽位 AI 算力卡(如 Atlas 系列),单卡 INT8 算力高达 352TOPS,可灵活适配不同 AI 推理与训练场景; • 百G级高速互联

CPU 直出多模式高速网络接口,包括 4×100G QSFP28、8×25G、8×10G 等组合,无需额外配置网卡,满足 AI 集群节点间高速数据交换需求; • 大模型本地化部署

预装 DeepSeek 系列大模型(涵盖 1.5B 至 32B 参数版本),实现 “开箱即用”,降低企业部署门槛; • 高密度集成设计

1U 机箱成双 CPU、可选 4 颗 NPU,兼顾高性能与空间效率,适配边缘机房、数据中心等多种场景。

SK90 智算一体机的存储配置同样灵活,单节点支持板载 SSD(128G 至 2T)与扩展 SSD,满足不同规模数据存储需求;搭配 1+1 冗余电源与宽温工作范围,可保障设备稳定运行。

深耕 AI 网络, 持续践行技术创新

未来,恒扬数据将持续在AI网络核心技术领域深耕,致力于成为客户最值得信赖的AI网络加速伙伴,通过不断创新和优化,为用户提供更优质的产品和服务,助力AI技术的发展和应用,推动智能计算时代的到来。