返回列表

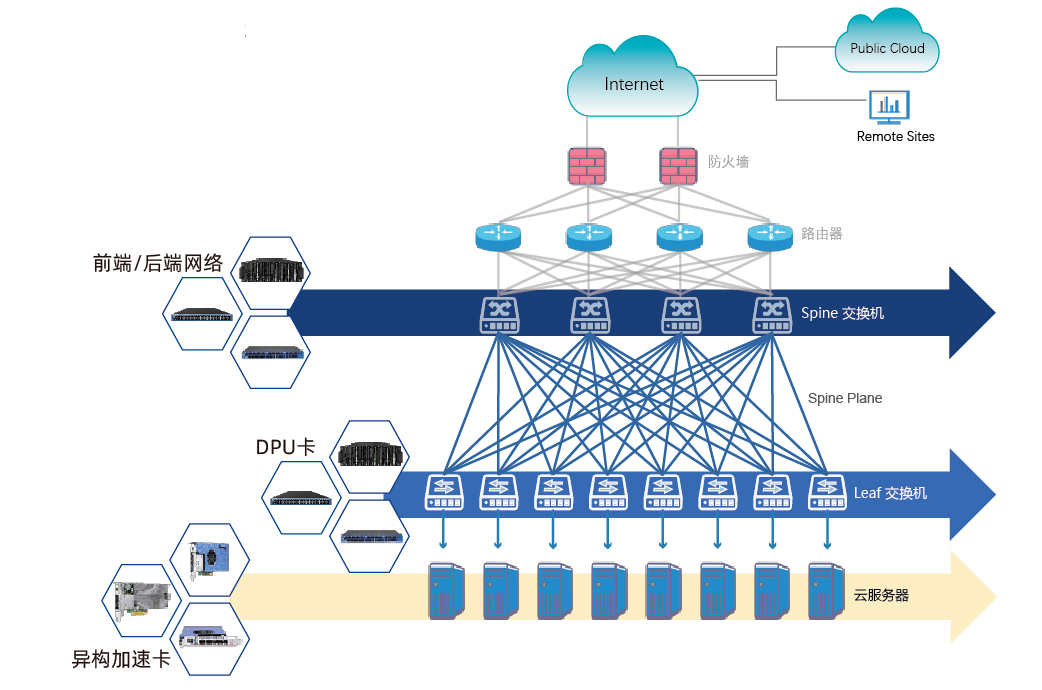

智算中心的 AI NIC 解决方案

智算中心的需求与挑战

随着AI模型的规模和复杂性不断增加,尤其是在深度学习和大数据处理的背景下,数据传输量剧增,网络容易成为系统性能的瓶颈。特别是在分布式计算环境中,节点之间的数据交换频繁,若网络带宽不足或延迟过高,会严重影响AI任务的执行效率,所以AI网络需要支持高带宽以便在节点之间快速传输大量数据。同时,低延迟是实时AI训练和推理的关键。

解决方案实现

- 接口速率: 提供单口400GE或双口200GE IO以及PCIe Gen5高速接口,能够满足AI计算和数据中心应用对带宽的严苛需求。

- DPU直达 NVMe 存储: 通过DPU直接连接 NVMe 存储设备,实现数据的高速读写,减少中间环节带来的延迟,从而显著提升系统的整体性能。

- RDMA 协议: 搭载标准/自研 RDMA协议,实现了远程内存访问的高效性和低延迟,适用于大规模数据处理和高性能计算任务。

- 自研通信库: 硬件结合自研通信库,能够实时感知业务需求,根据实际应用场景动态调整,优化数据传输路径和计算任务分配。

- 多路径高性能拥塞控制算法: 自研的多路径拥塞控制算法在高并发和高负载情况下,能够智能地选择最佳数据传输路径,避免网络拥塞,保障数据传输的稳定性和速度。

- 降低长尾时延: 硬件级重传机制有效减少了因网络波动和数据包丢失导致的延迟,长尾时延降低达 50%,显著减少了因重传带来的等待时间,提升了整体系统响应速度。